![]() 工具推荐

1719133749更新

工具推荐

1719133749更新

![]() 0

0

腾讯混元文生图大模型(简称混元DiT模型)近日宣布全面开源其训练代码。全球的企业和个人开发者、创作者现在可以基于混元DiT的训练代码进行个性化模型的精调,实现更高自由度的创作。此外,腾讯还开源了LoRA小规模数据集训练方案和ControlNet插件,为混元DiT模型的开源生态增添了更多可能性。

混元DiT模型作为中文原生模型,其训练代码支持直接使用中文数据和标签,省去了将数据翻译成英文的步骤。这一特性对于中文用户来说无疑是一大便利。自腾讯宣布混元文生图大模型全面升级并开源以来,其在Hugging Face平台及Github上受到了广泛关注,成为开源社区中热门的DiT模型之一,仅一个月内Github Star数就达到了2.4k。

LoRA模型,全称为Low-Rank Adaptation of Large Language Models,是一种微调大型语言模型的技术。在文生图模型中,LoRA被用作插件,允许用户在不改变原有模型结构和大小的情况下,通过少量数据训练出具有特定画风、IP或人物特征的模型。这种技术在文生图开源领域非常受欢迎,许多创作者利用LoRA技术创造出了多样化的模型。腾讯混元发布的LoRA插件支持开发者使用极少的图片和提示词来创作出专属的模型。例如,通过导入四张青花瓷图片和相应的提示词,就可以训练出一个“青花瓷”生成模型。用户只需输入简单的提示词,即可生成所需的青花瓷图像。

训练后模型的推理结果示例:

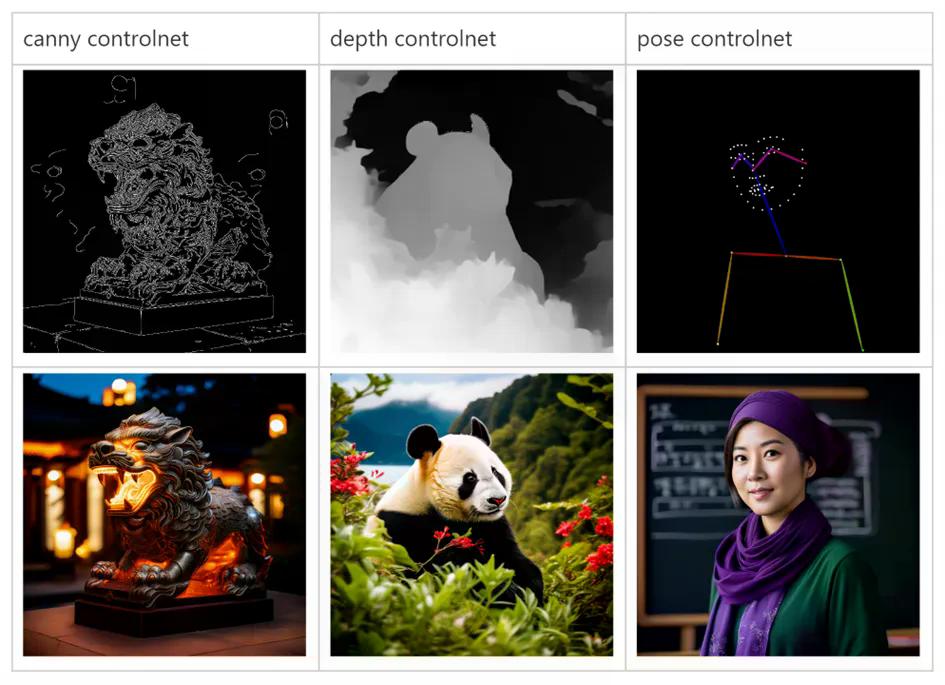

ControlNet插件则是一种可控化生成算法,它允许用户通过添加额外条件来控制图像的生成。腾讯混元提供了三个首发ControlNet模型,分别用于提取和应用图像的边缘、深度和人体姿势等条件。这些插件能够实现通过线稿生成全彩图、生成具有相同深度结构的图、生成具有相同姿态的人等能力。同时,混元DiT也开源了ControlNet的训练方案,使得开发者和创作者可以训练自定义的ControlNet模型。

自混元DiT模型开源以来,腾讯混元团队一直在持续完善和优化基于混元DiT的开源组件。本月初,混元DiT发布了专属加速库,将推理效率提升了75%,同时大幅提高了模型的易用性。用户现在可以通过ComfyUI的图形化界面使用混元DiT,或者通过Hugging Face Diffusers通用模型库,仅用三行代码即可调用混元DiT模型,无需下载原始代码库。

腾讯混元文生图的能力已经被广泛应用于素材创作、商品合成、游戏出图等多个业务和场景中。今年初,腾讯广告基于腾讯混元大模型发布了一站式AI广告创意平台腾讯广告妙思。此外,《央视新闻》《新华日报》等20余家媒体也已经将腾讯混元文生图用于新闻内容生产。

豫公网安备41010702003375号

豫公网安备41010702003375号