Hugging Face 推出开源大模型排行榜,中国模型称霸

![]() 前沿资讯

1719542514更新

前沿资讯

1719542514更新

![]() 0

0

Hugging Face发布全新开源大语言模型(LLM)排行榜,首席执行官克莱姆-德兰格(Clem Delangue)指出,以往的 LLM 基准对于最新的模型来说 "太容易了",就像 "用初中生的问题来让高中生考试"。

“随着开源语言模型的日益成熟,有必要进行更严格、更具挑战性的评估。”不过,德朗格也提醒说,一些 Al 开发者可能过于关注针对特定基准的优化,而忽略了模型的全面性能。

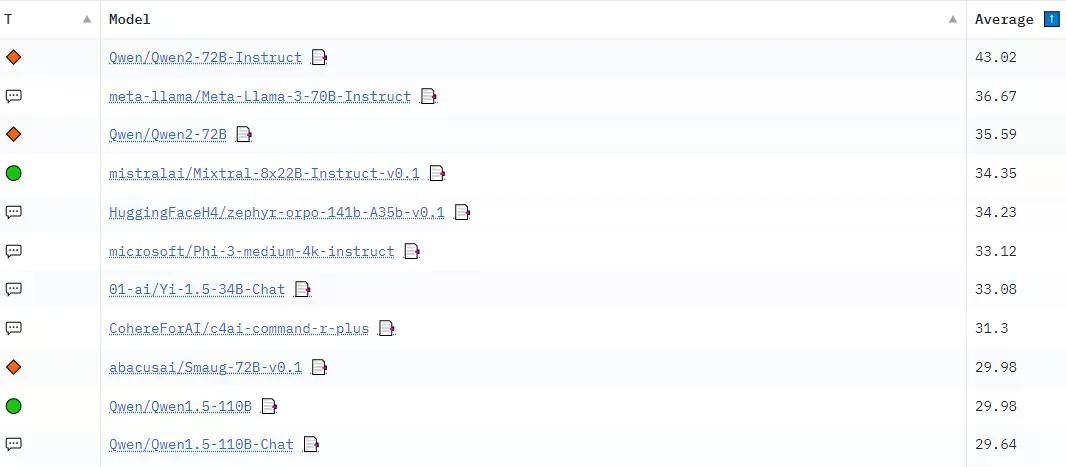

该排行榜采取新的评估方式对开源大模型进行排名,其中包括 MMLU-pro 基准,该基准是测试高中和大学水平问题的模型。Hugging Face利用300颗NVIDlA H100 GPU对所有主要开源LLM进行了重新评估,并更新了排名。中国模型在排行榜上占据了主导地位,阿里巴巴的 Qwen-72B 模型表现出色,超越了其他开源模型,位列第一。

Hugging Face的全新开源LLM排行榜,为大模型的客观性能展示提供了强有力的支持,也为大模型在评估方面的成熟度贡献了自己的一份力量。Hugging Face成立于2016年,已成为开源机器学习的中心枢纽,托管了超过25万个模型和数据集,供20万开发者社区使用。

豫公网安备41010702003375号

豫公网安备41010702003375号