![]() 前沿资讯

1737108389更新

前沿资讯

1737108389更新

![]() 1

1

This Rumor About GPT-5 Changes Everything(译文)

倘若告诉你,GPT-5是真实存在的呢?它不仅真实,还已在潜移默化中塑造着世界,只是你尚未察觉。这里有一个假设:OpenAI开发了GPT-5,但选择将其内部使用,因为相比向数百万ChatGPT用户推出,内部使用能带来更大的投资回报。而且,他们获取的回报并非金钱,而是其他东西。难点在于将指向这一结论的线索串联起来。本文将深入探讨我为何认为这一切是合理的。

需要明确的是,这纯粹是猜测。虽然证据是公开的,但并没有泄密或内部传闻能证实我是对的。事实上,我写这篇文章就是为了把这理论给搭建起来,可不是单纯传递一个观点而已。我没有内部消息,即便有,也会受到保密协议的约束。这个猜想极具说服力,因为它合乎情理。说真的,我还能做些什么来让这个传言传播得更广呢?

这得由你来评判我是否合理。即便我错了——最终我们会知晓答案——我觉得这也是一次有趣的推理练习。我邀请你在评论区一同推测,但请保持建设性和深度思考。另外,请先通读全文。除此之外,欢迎展开各种讨论。

一、神秘消失的Opus 3.5

在探讨GPT-5之前,我们得先关注一下它“失联”的远亲,同样行踪成谜的Anthropic公司的Claude Opus 3.5。

众所周知,排名前三的人工智能实验室OpenAI、谷歌DeepMind和Anthropic提供了一系列模型,旨在覆盖价格/延迟与性能的不同区间。OpenAI提供了诸如GPT-4o、GPT-4o mini,以及o1和o1-min等选择;谷歌DeepMind有Gemini Ultra、Pro和Flash;Anthropic则有Claude Opus、Sonnet和Haiku。其目标很明确:尽可能满足各类客户的需求。有些客户无论成本如何,都优先追求顶级性能,而另一些则寻求价格合理、性能尚可的解决方案。到目前为止,一切都还正常。

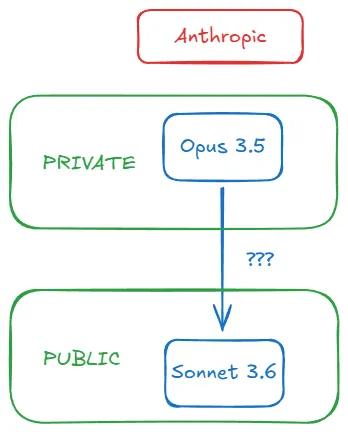

但在2024年10月,奇怪的事情发生了。大家都期待Anthropic能推出Claude Opus 3.5,以应对OpenAI于2024年5月推出的GPT-4o。然而,在10月22日,Anthropic发布了Claude Sonnet 3.5的更新版本(人们开始称之为Sonnet 3.6),Opus 3.5却不见踪影,这使得Anthropic似乎缺少了能与GPT-4o直接竞争的产品。很奇怪,对吧?以下是关于人们的言论以及Opus 3.5实际情况的时间线梳理:

- 10月28日,我在每周更新中写道:“有传言称Sonnet 3.6是……备受期待的Opus 3.5的中间过渡版本。”同样在10月28日,r/ClaudeAl论坛上出现了一篇帖子,标题为“Claude 3.5 Opus已被废弃”,并附上了Anthropic模型页面的链接,截至今日,该页面仍未提及Opus 3.5。一些人推测,在即将到来的融资轮之前,将其从页面移除是为了维护投资者的信任而采取的战略举措。

- 11月11日,Anthropic的Dario Amodei在Lex Fridman的播客中否认他们放弃了Opus 3.5,他表示:“我无法给出确切日期,但就我们而言,Claude 3.5 Opus仍在推进中。”言辞谨慎且含糊,但也算有所表态。

- 11月13日,彭博社发声,证实了此前的传闻:“在完成训练后,Anthropic发现3.5 Opus在评估中的表现优于旧版本,但考虑到模型的规模以及构建和运行的成本,其提升幅度未达预期。”看来Dario没有给出发布日期,是因为尽管Opus 3.5的训练没有失败,但其结果不尽人意。需要注意的是,这里强调的是相对于性能的成本,而非单纯的性能。

- 12月11日,半导体专家Dylan Patel及其Semianalysis团队给出了最终的反转解释:“Claude 3.5 Opus完成了训练,且表现良好,具备相应的扩展性……然而Anthropic并未将其公开发布。这是因为Anthropic没有选择公开发布,而是利用Claude 3.5 Opus生成合成数据,并进行奖励建模,结合用户数据,大幅提升了Claude 3.5 Sonnet的性能。”

简而言之,Anthropic确实对Claude Opus 3.5进行了训练,之所以弃用这个名称,是因为其表现不够出色。Dario对通过差异化训练能够改善结果充满信心,因此没有给出发布日期。彭博社证实,该模型的结果虽优于现有模型,但不足以证明投入的成本合理。Dylan和他的团队揭示了神秘的Sonnet 3.6与失踪的Opus 3.5之间的联系:后者被用于内部生成合成数据,以提升前者的性能。

我们可以这样理解:

二、性能更佳,体积更小且成本更低?

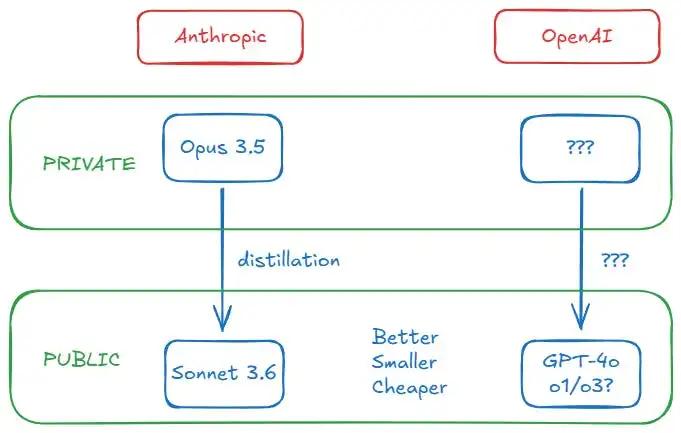

利用强大且昂贵的模型生成数据,进而提升性能稍逊但更实用的模型,这一过程被称为蒸馏。这是一种常见的做法,能让人工智能实验室在仅靠额外预训练无法实现的情况下,提升小型模型的性能。

蒸馏的方法有很多种,我们在此不做深入探讨。你只需记住,一个强大的“教师”模型可以将“学生”模型从[小型、廉价、快速]+性能较弱转变为[小型、廉价、快速]+性能强大。蒸馏可以让强大的模型更高效地发挥作用,因此Anthropic对Opus 3.5和Sonnet 3.6这对组合采用这种方式是合理的。

/ 新Sonnet模型与旧版相比,推理成本并未大幅变化,但性能却得到了提升。那么,既然从成本角度考虑,发布3.5 Opus不如发布经过3.5 Opus进一步后训练的3.5 Sonnet更具经济意义,为何还要发布3.5 Opus呢?

我们又回到了成本和蒸馏的话题上。蒸馏既能降低推理成本,又能提升性能,这是解决彭博社所报道问题的即时方案。Anthropic选择不发布Opus 3.5,是因为它在内部有更有价值的用途。(Dylan认为,这就是开源社区能如此迅速赶上GPT-4的原因——他们直接从OpenAI的“宝藏”中获取精华。)

最惊人的发现是什么呢?Sonnet 3.6不仅表现出色,而且达到了顶尖水平,比GPT-4o还要好。Anthropic的中端模型超越了OpenAI的旗舰产品,这得益于蒸馏技术,当然可能还有其他原因。五个月的时间在人工智能领域是一段很长的时间,而参数数量已不再是衡量高性能的可靠指标。

“越大越好”的时代已经过去了吗?OpenAI的Sam Altman曾警告过这一点,我也写过相关内容。一旦顶尖实验室变得神秘兮兮,小心翼翼地守护着他们珍贵的知识,他们就不再分享数据。参数数量不再是可靠的衡量标准,我们也明智地将关注点转移到了基准性能上。OpenAI最后一次官方披露的模型规模是2020年的GPT-3,拥有1750亿个参数。到了2023年6月,有传言称GPT-4是一个专家混合模型,总参数约为1.76万亿。Semianalysis随后在详细评估中证实了这一点,结论是GPT-4有1.76万亿个参数,时间是2023年7月。

直到2024年12月,也就是一年半之后,EpochAI(一个关注人工智能未来影响的组织)的研究员Ege推测,一批领先的人工智能模型,包括GPT-4o和Sonnet 3.6,明显比GPT-4小(尽管它们在各项基准测试中的表现均优于GPT-4):

/ “……当前的前沿模型,如最初的GPT-4o和Claude 3.5 Sonnet,其规模可能比GPT-4小一个数量级,GPT-4o约有2000亿个参数,3.5 Sonnet约有4000亿个参数……不过,鉴于我得出这一估算的方法较为粗略,该估算结果可能有两倍的误差。”

他深入解释了在实验室未公布任何架构细节的情况下,他是如何得出这个数字的,但这对我们来说并不重要。重要的是,迷雾正在散去:Anthropic和OpenAI似乎都在遵循类似的策略。他们的最新模型不仅性能更优,而且比上一代体积更小、成本更低。我们知道Anthropic是如何通过将Opus 3.5蒸馏到Sonnet 3.6中实现这一目标的。但是,OpenAI做了什么呢?

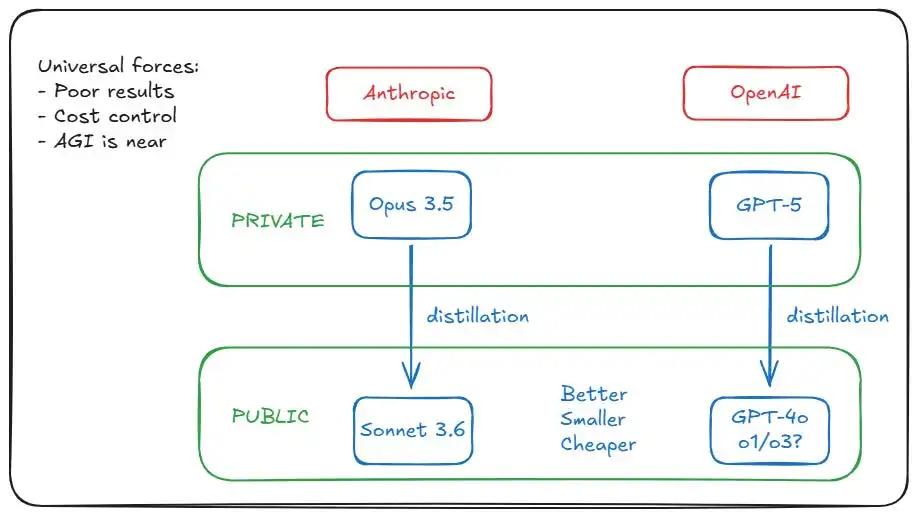

三、推动人工智能实验室的力量具有普遍性

有人可能认为,Anthropic的蒸馏方法是由特殊情况驱动的,即Opus 3.5的训练效果不佳。但事实是,Anthropic的情况并非个例。谷歌DeepMind和OpenAI在其最新的训练中也都报告了不尽人意的结果(要记住,结果不尽人意并不意味着模型更差)。其原因对我们来说并不重要,可能是数据不足导致的收益递减、Transformer架构固有的局限性,或者是预训练缩放定律达到了瓶颈等等。无论如何,Anthropic的特殊情况实际上相当普遍。

但要记住彭博社的报道:性能指标的好坏取决于成本。这是另一个共同因素吗?是的,Ege对此进行了解释。在ChatGPT/GPT-4热潮之后,生成式人工智能的需求激增,其受欢迎程度增长如此之快,以至于实验室难以跟上,从而导致损失不断增加。这种情况促使所有实验室降低推理成本(训练只需进行一次,但推理成本与用户数量和使用量成正比)。如果每周有3亿人使用你的人工智能产品,运营支出可能会瞬间将你压垮。

推动Anthropic从Opus 3.5蒸馏出Sonnet 3.6的因素,正以数倍的力量影响着OpenAI。蒸馏之所以有效,是因为它解决了两个普遍存在的挑战:一方面,通过向用户提供小型模型,解决了推理成本问题;另一方面,通过不发布大型模型,避免了因性能不佳而引发的公众不满。

Ege提出,OpenAI可能选择了另一种方法——过度训练。其理念是在比计算最优数量更多的数据上训练小型模型,即“当推理成为你在模型上支出的主要或主导部分时,最好……在更多的标记上训练小型模型”。但过度训练已不再可行,人工智能实验室已经耗尽了用于预训练的高质量数据来源。埃隆·马斯克和伊利亚·苏茨克弗在最近几周也承认了这一点。

我们又回到了蒸馏这一方法上。Ege总结道:“我认为GPT-4o和Claude 3.5 Sonnet很可能都是由更大的模型蒸馏而来的。”

目前的每一个线索都表明,OpenAI正在做与Anthropic对Opus 3.5所做的相同的事情(训练并隐藏模型),采用相同的方法(蒸馏),出于相同的原因(结果不佳/成本控制)。这是一个重大发现。但是,Opus 3.5仍然存在,OpenAI类似的模型在哪里呢?它是否藏在公司的“地下室”里?不妨大胆猜测一下它的名字……

四、开拓者需披荆斩棘

我通过研究Anthropic的Opus 3.5事件展开这一分析,因为我们对这个案例掌握的信息更多。然后,我通过蒸馏这一概念将其与OpenAI联系起来,并解释了推动Anthropic的潜在力量为何也同样作用于OpenAI。然而,我们的理论遇到了一个新的障碍:由于OpenAI是先驱者,他们可能面临着Anthropic等竞争对手尚未遇到的困难。

其中一个障碍是训练GPT-5所需的硬件条件。Sonnet 3.6与GPT-4o相当,但它的发布时间较晚。我们可以假设GPT-5更强大、规模更大,因此不仅推理成本更高,训练成本也更高。我们谈论的可能是一笔高达数亿美元甚至数十亿美元的投资。那么,以目前的硬件条件,是否有可能启动这样的训练呢?

Ege再次给出了解答:是的。为3亿人提供如此强大的模型服务可能难以承受,但训练呢?小菜一碟:

/ 原则上,即使是我们现有的硬件,也足以支持比GPT-4大得多的模型。例如,一个比GPT-4规模扩大50倍、约有100万亿参数的模型,可能以每百万输出标记3000美元的成本提供服务,输出速度为每秒10-20个标记。

然而,要使这一方案可行,这些大型模型必须为使用它们的客户创造巨大的经济价值。然而,即使对于微软、谷歌或亚马逊(分别是OpenAI、DeepMind和Anthropic的资助者)来说,花费如此巨额的推理资金也是不合理的。那么他们如何解决这个问题呢?很简单,如果他们计划向公众提供拥有数万亿参数的模型,就需要创造巨大的经济价值,但他们没有这样做。

他们进行了训练,发现它“比当前的产品表现更好”,但也不得不承认,它“还没有先进到足以证明维持其运行所需的巨额成本是合理的”。(这种措辞听起来熟悉吗?这与一个月前《华尔街日报》对GPT-5的报道如出一辙,与彭博社对Opus 3.5的描述也惊人地相似。)

他们报告了不尽人意的结果(或多或少是准确的,他们总能在说法上做文章),将其作为一个大型的“教师”模型保留在内部,用于蒸馏较小的“学生”模型,然后发布这些小型模型。于是我们得到了Sonnet 3.6、GPT-4o和o1,并且对它们价格低廉且性能良好感到非常满意。尽管我们越来越不耐烦,但对Opus 3.5和GPT-5的期待依然未减。而他们的“钱袋子”也像金矿一样闪闪发光。

五、奥特曼先生,你肯定还有更多理由!

在我的调查进行到这一步时,我仍然心存疑虑。诚然,所有证据都表明,这种情况对OpenAI来说完全合理,但合理甚至看似可能,并不等同于事实。我不会为你填补这个差距——毕竟这只是纯粹的猜测。但我可以进一步强化这个观点。

是否有其他证据表明OpenAI采取了这种做法呢?除了性能不佳和损失增加之外,他们还有更多理由扣留GPT-5吗?我们能从OpenAI高管关于GPT-5的公开声明中推断出什么呢?他们反复推迟模型发布,难道不怕损害自己的声誉吗?毕竟,OpenAI是人工智能革命的典型代表,而Anthropic则在其光环之下运作。Anthropic可以采取这些举措,但OpenAI呢?或许不能毫无代价地这样做。

说到钱,让我们挖掘一些关于OpenAI与微软合作的相关细节。首先,众所周知的是AGI条款。在OpenAI关于其结构的博客文章中,有五项治理条款规定了其运作方式、与非营利组织、董事会以及与微软的关系。第五条条款将AGI定义为“一种高度自主的系统,在大多数具有经济价值的工作中表现优于人类”,并规定一旦OpenAI董事会宣布已实现AGI,“这样的系统将被排除在与微软的知识产权许可和其他商业条款之外,这些条款仅适用于AGI之前的技术”。

不用说,两家公司都不希望合作关系破裂。OpenAI制定了这条条款,并且会竭尽全力避免触发它。一种方法就是推迟发布可能被认定为AGI的系统。但你可能会说:“GPT-5肯定不是AGI。”我会告诉你第二个几乎无人知晓的事实:OpenAI和微软对AGI有一个秘密定义,虽然这个定义在科学层面无关紧要,但在法律层面却构成了他们合作关系的框架。AGI是指“能够产生至少1000亿美元利润”的人工智能系统。

如果OpenAI以GPT-5尚未准备好为由扣留它,除了控制成本和避免公众不满之外,他们还能实现另一个目的:回避是否宣布它达到AGI标准的问题。虽然1000亿美元的利润是一个天文数字,但雄心勃勃的客户完全有可能基于它创造出这么多的利润。另一方面,需要明确的是,如果OpenAI预计通过GPT-5每年能获得1000亿美元的利润,他们就不会介意触发AGI条款并与微软分道扬镳。

大多数人对OpenAI不发布GPT-5的反应,都基于其性能不够好这一假设。即便这是真的,也没有质疑者停下来思考,OpenAI在内部使用该模型,可能比对外发布能获得更好的效果。创造一个优秀的模型,与创造一个能以低成本向3亿人提供服务的优秀模型,两者之间存在着巨大的差异。如果你做不到,那就不要做。但如果没必要做,那也不用做。他们曾经让我们使用他们最好的模型,是因为他们需要我们的数据,而现在这种需求没那么强烈了。他们也不是为了赚我们的钱,那是微软的目的,而非OpenAI的。OpenAI追求的是通用人工智能(AGI),然后是超级人工智能(ASI),他们想要留下深远的影响。

六、为什么这会改变一切

我们即将得出结论。我认为已经提出了足够多的论据来支撑这一观点:OpenAI很可能已经在内部运行GPT-5,就像Anthropic对Opus 3.5所做的那样。甚至有可能OpenAI永远都不会发布GPT-5。如今,公众衡量性能的标准不再仅仅是GPT-4o或ClaudeSonnet 3.6,还包括o1/o3。随着OpenAI探索测试时的缩放定律,GPT-5需要跨越的门槛不断提高。他们怎么可能以目前推出o系列模型的速度,发布一个真正超越o1、o3以及即将推出的o系列其他模型的GPT-5呢?此外,他们不再需要我们的钱或数据了。

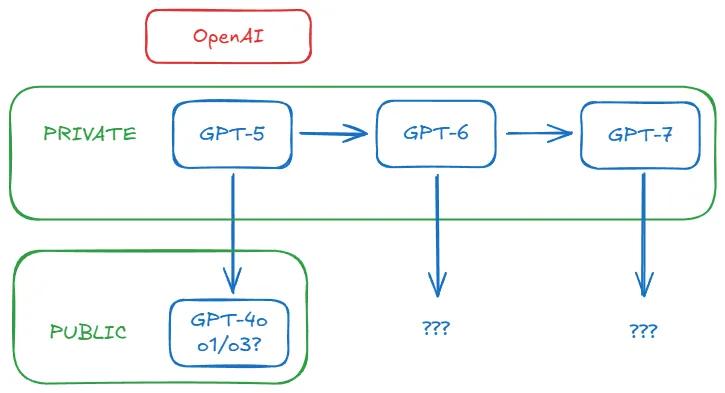

对OpenAI来说,在内部训练新的基础模型,如GPT-5、GPT-6等等,始终是有意义的,但不一定会将它们作为产品推出。产品化的时代或许已经结束。他们现在唯一重要的目标是持续为下一代模型生成更好的数据。从现在起,基础模型可能会在幕后运行,赋能其他模型去实现它们自身无法达成的成就——就像一位隐居在神秘山洞中的老智者,将智慧传承下去,只不过这个山洞是一座庞大的数据中心。无论我们是否见过他,我们都将感受到他智慧所带来的影响。

即使GPT-5最终发布,其影响也可能微乎其微。如果OpenAI和Anthropic真的启动了递归自我改进计划(尽管可能还需要人类参与其中),那么他们在公开层面展示给我们的东西就无关紧要了。他们会把竞争对手甩得越来越远——就像宇宙快速膨胀,以至于遥远星系的光都无法再抵达我们。

也许这就是OpenAI在短短三个月内从o1发展到o3的原因,也是他们将如何迈向o4和o5的方式。这可能就是他们最近在社交媒体上如此兴奋的原因,因为他们已经实施了一种全新且更优的运作模式。

你真的以为接近通用人工智能意味着我们能随时使用到越来越强大的人工智能吗?以为他们会发布每一项进展供我们使用?想必你不会这么认为。他们曾说过,他们的模型会将他们带向远方,让其他人望尘莫及,他们是认真的。每一代新模型都是推动他们加速前进的逃逸引擎。他们已经从平流层向我们挥手告别了。

至于他们是否会回归,还有待观察。

豫公网安备41010702003375号

豫公网安备41010702003375号