![]() 工具推荐

1737190182更新

工具推荐

1737190182更新

![]() 0

0

自然界中的“适应能力”是一种令人赞叹的现象,比如章鱼通过改变皮肤颜色与周围环境融为一体,又比如人类大脑在因伤害失去功能后能够适应性地重塑神经通路。这些机制使得生命得以在不断变化的环境中蓬勃发展。而今,这种适应能力正成为人工智能领域的热门研究方向。

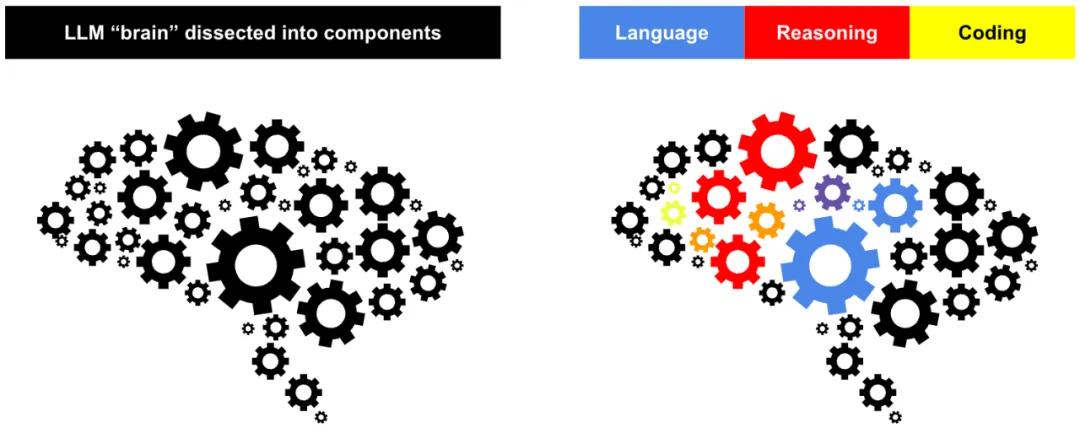

传统的大语言模型如Llama、Mistral等,通过训练数据构建固定的权重矩阵来存储信息,因此只能以一种相对静态的方式处理任务。日本Sakana AI团队提出一个可以通过动态调整模型权重以适应不同任务的Transformer²架构。Transformer²从自然界和人类智能中获取灵感,提出了一种全新的动态自适应机制。它通过奇异值分解(SVD)对权重矩阵进行拆解,将复杂知识分解为独立的核心组成部分。这些部分类似于模型的“精神路径”,可以独立作用于不同任务。

Transformer²的核心技术创新之一在于训练阶段的奇异值调优(SVF)。在这一过程中,系统为每个特定任务学习一种向量表示,即z-vector。这些z-vectors可以看作“任务专家”,通过调节权重矩阵中不同成分的比重,让模型能够实现对不同任务需求的响应。例如,对于一个包含五个成分[A, B, C, D, E]的权重矩阵,数学任务的z-vector可能为[1, 0.8, 0, 0.3, 0.5],表示A对于任务至关重要,而C则几乎没有作用。然而,对语言处理任务而言,z-vector可能是[0.1, 0.3, 1, 0.7, 0.5],因为此时C才是核心成分。通过强化学习的机制,Transformer²能够为多种任务高效学习这些z-vectors,并且只需极少的参数增量即可显著提升模型性能。

在推理阶段,Transformer²采用两步式方法完成动态适应。第一步是任务检测,系统通过自动分析任务类型选择最为匹配的z-vector。具体检测方法包括基于提示的任务分类、通过分类器识别任务,或通过少样本学习将多个z-vectors进行加权组合。完成任务检测后,模型通过动态组合这些z-vectors调整权重矩阵,从而为特定任务生成最优的输出。由此,Transformer²不仅提升了推理效率,还显著增强了在多任务场景中的适用性。

实验结果显示,Transformer²的性能在多领域任务上表现优异,包括数学推理(如GSM8K任务集)、代码生成、人类逻辑推断以及视觉问答等场景。尤其在数学领域,与传统的LoRA方法相比,Transformer²通过SVF实现了显著的性能突破。这归功于强化学习可以让模型处理不完美答案场景,从而在复杂问题上更具鲁棒性。此外,Transformer²展现出跨领域知识融合的能力,例如在解决复杂数学问题时,模型会综合使用数学、编程、逻辑推理等不同任务的z-vectors,而非专注于单一任务。这一发现进一步佐证了该框架在知识整合上的潜力。

不仅如此,Transformer²还具有令人惊喜的跨模型适用性。在一项关键实验中,使用从Llama模型学到的z-vectors迁移到Mistral模型,可以发现后者在处理多项任务时性能明显提高,表明Transformer²实现了一种跨模型的“知识共享”。虽然目前这种迁移的效果更多依赖于模型架构的相似性,但这一成果让人们看到了进一步将任务专长迁移到新一代模型的广阔前景。

从最早的静态模型到如今的动态自适应系统,Transformer²的提出有望让后期的AI系统脱离频繁再训练的需求,实时调整其行为以适应复杂外部环境的变化。同时,它也能实现任务能力的持续升级,甚至在未来实现不同AI系统间的协作,满足更高度集成化的智能需求。正如自然界中的生物依靠惊人的适应能力创造了生命奇迹,Transformer²为构建终身学习型AI系统开辟了一条新道路。

豫公网安备41010702003375号

豫公网安备41010702003375号