![]() 工具推荐

1737966996更新

工具推荐

1737966996更新

![]() 1

1

传统的机器写作通常依赖检索增强生成技术。这种方式就像是在一个固定的信息库里找资料,找到的信息往往比较浅,还有很多重复的内容,导致写出来的文章质量往往不高,内容浅显、重复,还缺乏新意。

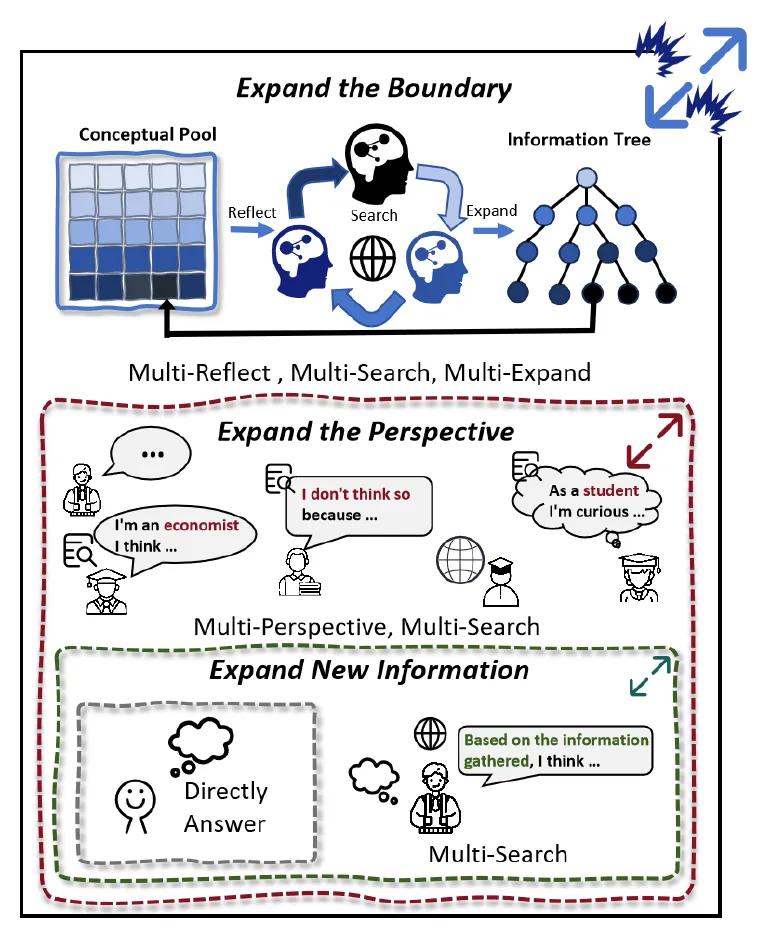

为了解决这些问题,通义实验室联合浙江大学的研究人员提出了OmniThink框架,该框架受到人类写作过程中不断思考、整合信息这一特点的启发,可以模拟人类在写作时不断扩展知识和反思的过程。OmniThink把机器写作分成了三个主要步骤。

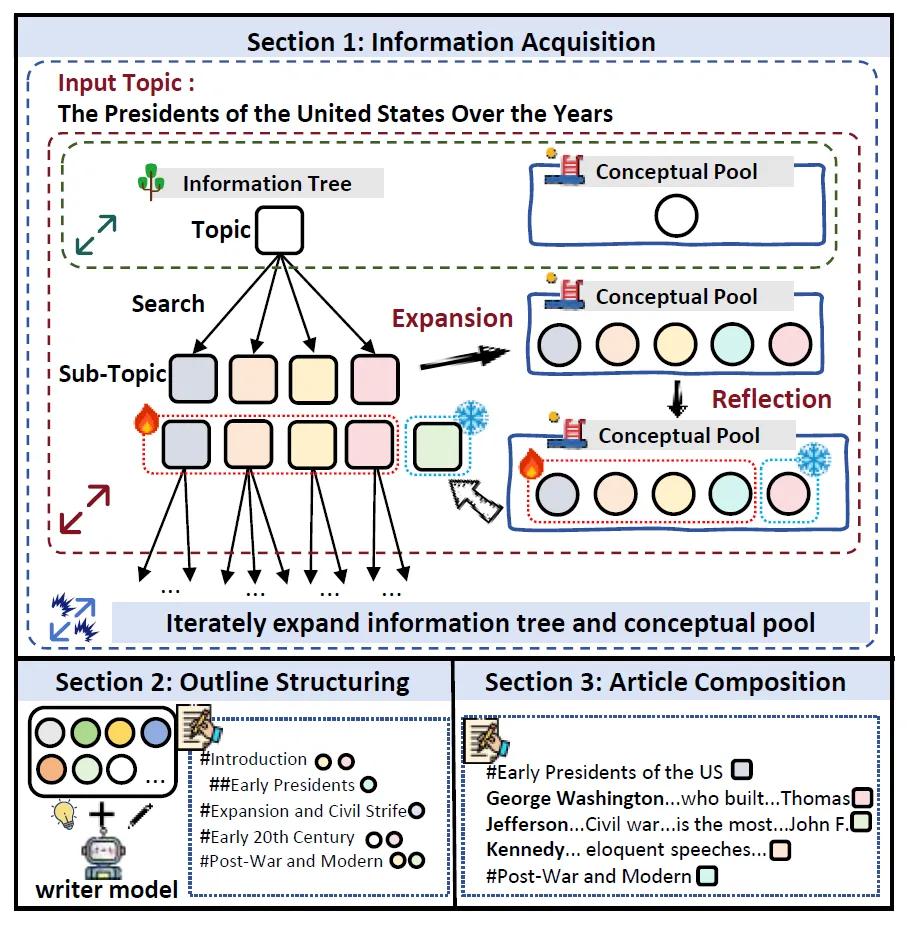

第一步是获取信息。OmniThink会不断深入了解要写的主题。它先根据输入的主题,利用搜索引擎找到一些相关信息,建立起一个信息树的“根基”,同时形成一个初步的概念池。之后,它会对信息树的“叶子节点”进行分析,看看哪些地方还需要进一步探索。如果发现有需要扩展的节点,就会从当前的概念池中寻找方向,生成一些子节点,然后再去检索相关信息,把这些信息添加到信息树中。在这个过程中,它还会对新找到的信息进行反思,把有价值的核心内容提炼出来,添加到概念池中,不断丰富自己对主题的理解。这个扩展和反思的过程会一直持续,直到获取到足够的信息。

第二步是构建大纲。大纲对于一篇文章来说非常重要,它决定了文章的方向和结构。OmniThink会先创建一个初步的大纲草稿,然后根据之前形成的概念池,让模型对草稿进行完善和细化,让大纲能够全面涵盖主题的要点,并且逻辑清晰、连贯。

第三步是撰写文章。有了完善的大纲后,OmniThink会让模型根据大纲各部分的标题,从信息树中找到最相关的信息,之后生成各个部分的内容。生成所有部分后,会把它们组合成一篇完整的文章草稿。由于各个部分是并行生成的,可能会存在一些冗余信息,所以最后还会让模型对整篇文章进行处理,去除重复的内容,形成最终的文章。

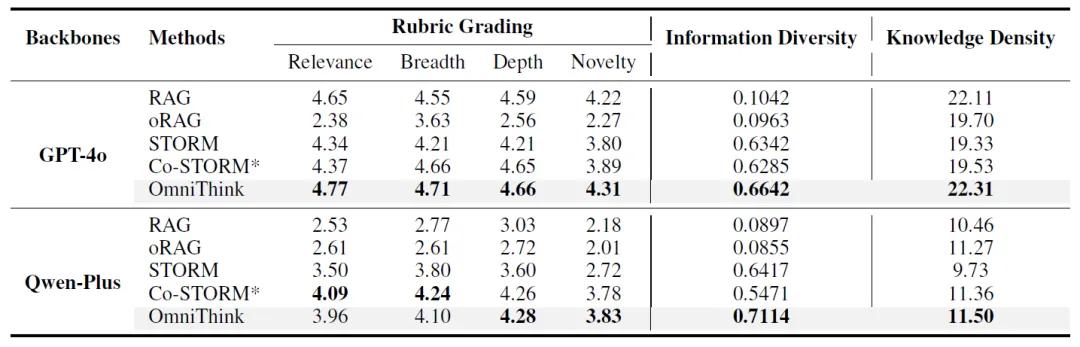

为了验证OmniThink的效果,研究人员进行了一系列实验。他们选择了WildSeek数据集,并把RAG、oRAG、STORM和Co-STORM等方法作为对比的基线。评估过程采用了自动评估和人工评估两种方式,自动评估使用Prometheus2这个工具,从相关性、广度、深度、新颖性等多个方面对文章进行打分,同时还会测量信息多样性和知识密度。人工评估则邀请了15位志愿者,对比OmniThink和表现最好的基线方法Co-STORM生成的文章。

实验结果显示,OmniThink在多个方面表现出色。在自动评估中,以GPT-4o为基础模型时,它在相关性、广度、深度、新颖性等关键指标上都表现优异,在知识密度方面也超过了其他方法。在大纲生成方面,OmniThink生成的大纲在结构合理性和逻辑一致性上表现更好。消融研究表明,动态扩展和反思机制对提升信息多样性和文章新颖性起着关键作用。从人工评估结果来看,OmniThink在多个维度上的平均表现超过了Co-STORM,不过在新颖性方面,自动评估和人工评估的结果存在差异,表明目前的自动评估方法还有改进的空间。

OmniThink机器写作框架通过模拟人类的思维过程,在提升文章质量方面取得了不错的效果。不过,该框架也存在一些局限,比如目前还没有利用多模态信息,生成的文章语言风格也比较单一。未来,研究人员计划进一步探索更先进的机器写作方法,让机器写作变得更加智能、高效,为人们提供更优质的内容。

豫公网安备41010702003375号

豫公网安备41010702003375号