![]() 前沿资讯

1742543516更新

前沿资讯

1742543516更新

![]() 0

0

近年来,人工智能不仅取得了技术突破,还吸引了大量金融投资。像ChatGPT、Claude或Gemini等强大人工智能系统的开发,从根本上改变了公众对这项技术的认知。然而,虽然讨论往往围绕伦理问题、社会影响或技术里程碑展开,但一个关键方面却常常被忽视:现代人工智能系统开发和运行所涉及的巨额成本。

人工智能开发的资金规模令人咋舌。据说OpenAI仅训练GPT-4就花费了超过5.4亿美元。其他公司,如谷歌在其人工智能基础设施上投入了数十亿美元。Anthropic完成了价值数十亿美元的融资轮,其中很大一部分直接用于其人工智能模型的开发和训练。xAI仅为其超级集群的硬件就花费了30-40亿美元,更不用说“星门计划”(Project Stargate),其投资额估计高达5000亿美元。这些数字引发了重要问题:资金究竟流向何处?哪些成本因素主导着人工智能的开发?对于整个行业,以及想要使用人工智能技术的公司和组织而言,长期的经济影响又是什么?

因此,本文的假设是,人工智能开发成本在各种因素之间分布不均,模型训练和所需基础设施是最大的成本驱动因素,与此同时,新的商业模式正在不断涌现,以摊销这些巨额投资。

训练成本因素:为何训练人工智能模型需花费数百万美元

训练现代人工智能模型,尤其是大型语言模型,是人工智能生态系统中最大的成本因素之一。这一过程不仅需要巨大的计算资源,还需要专用硬件、数据和专家。不过,一般来说,可以认为推理阶段比训练阶段消耗和需要更多的计算资源。

态势感知公司的利奥波德·阿申布伦纳(Leopold Aschenbrenner)认为“总体投资可能还要大得多:很大一部分GPU可能会用于推理,即实际在产品中运行人工智能系统,而且在这场竞赛中,可能有多个参与者拥有巨型集群。”然而,总体而言,许多人工智能公司在具体数据方面仍守口如瓶。例如,从众多报道中可以了解到GPT-4的训练成本,但对于GPT-4.5或o系列却一无所知。

计算成本

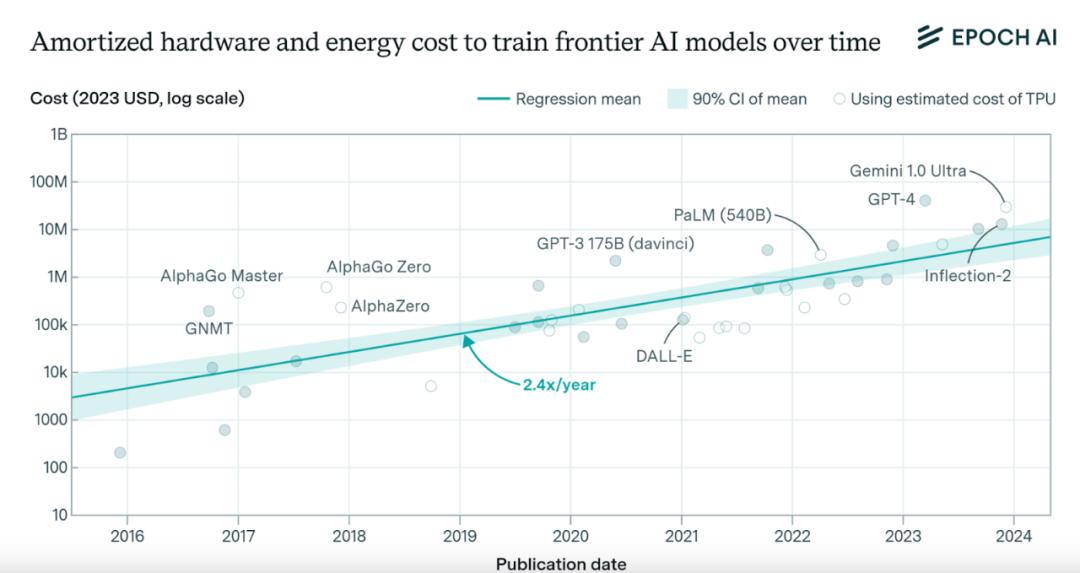

训练先进人工智能模型的计算成本极高。OpenAI首席执行官萨姆·奥特曼曾公开表示,训练GPT-4的成本“超过1亿美元”。其他估算则高达5.4亿美元。相比之下,其前一代模型GPT-3的训练成本估计约为460万美元,短短几年内增长了20到100倍。这种成本的指数级增长遵循着人工智能研究人员观察到的一种趋势:训练最先进的人工智能模型所需的计算能力大约每3、4个月就会翻一番,这一速度比传统适用于计算机硬件的摩尔定律要快得多。

具体数据可以说明这一情况:

据估计,GPT-4的训练在几个月内消耗了25000个英伟达A100 GPU。按照目前A100 GPU每GPU小时约1-3美元的云服务价格计算,仅GPU使用成本就高达数亿美元。Anthropic公司曾表示,训练其最新模型Claude 3花费了“数千万美元”。

硬件成本

训练成本的很大一部分来自专用硬件,特别是图形处理单元(GPU)。英伟达凭借其A100、H100(以及现在的H200)等专为人工智能工作负载优化的型号主导了这一市场。

这种硬件成本高昂:目前,单个英伟达H100芯片的成本约为2.5万至4万美元。一个典型的大型语言模型训练系统由数千个这样的芯片组成。谷歌报告称,其为TPU v4系统(张量处理单元)投资超过5亿美元。此外,还需要加上冷却系统、电源供应和其他基础设施的成本。而且,这种硬件的使用寿命有限,大约3-5年就需要被更强大的新一代产品取代,这导致了定期的再投资周期。

数据成本

虽然数据成本通常低于计算成本,但仍然不可忽视:获取高质量、经过整理的数据集可能很昂贵(例如,ScaleAI这类公司专门致力于整理和创建数据集)。为训练获取受版权保护内容的许可需要花费数百万美元。数据的人工标注和质量保证需要人力投入。存储和管理PB级的训练数据会产生持续成本。例如,Anthropic公司表示,为训练Claude模型创建高质量、经过筛选的数据集花费了数百万美元。

人工成本

一个常常被低估的成本因素是开发和训练人工智能模型所需的高素质专家:拥有博士学位的人工智能研究人员和工程师的年薪通常在30万美元到超过100万美元之间。大型公司中一个典型的人工智能研究团队由几十到几百名这样的专家组成。在这个竞争激烈的领域,为了吸引和留住人才,需要以股票期权和其他激励措施的形式进行额外投资。一个人工智能研究团队仅人员成本每年就很容易达到1000万至2000万美元。

基础设施成本:人工智能发展的基础

除了直接的训练成本,基础设施成本是另一个重要的成本因素,却常常受到较少关注。

数据中心

人工智能开发和运行的物理基础设施成本高昂,建造一个现代化、针对人工智能优化的数据中心可能需要5亿美元到数十亿美元不等。人工智能数据中心的能源成本巨大,训练一个大型模型的单次训练过程所消耗的电量,可能相当于一个小村庄几个月的用电量,再加上推理阶段持续的电力成本。Meta宣布,到2024年,其将在人工智能基础设施上总计投资90亿美元。微软为其Azure云平台进行了超过500亿美元的基础设施投资,该平台托管了包括OpenAI模型在内的众多模型。

网络基础设施

人工智能系统的分布式训练和运行所需的网络基础设施包括:GPU集群之间的高速网络连接。用于低延迟交付人工智能服务的全球网络基础设施。用于高可用性的冗余系统。例如,谷歌每年在其全球网络基础设施上投资数十亿美元,这也为其人工智能服务提供了支持。

维护和运营

人工智能基础设施的持续维护和运营成本也相当惊人。

能源成本:大型人工智能数据中心消耗数十到数百兆瓦的电力。

冷却系统:现代GPU会产生大量热量,需要进行散热处理。

维护人员:需要技术人员和工程师进行全天候运营。

安全和合规成本:包括物理和数字安全措施,以及遵守监管要求的成本。

一个现代化的人工智能数据中心,每年除硬件成本外,运营成本可能高达1000万至2000万美元。

把以上开支成本项加一起的话,人工智能模型开发资金规模令人咋舌,刨开技术能力先不谈,烧钱规模也不是一般企业能吃得消,这也在无形之中形成了一个愈来愈宽广的鸿沟。

参考资料:https://www.forwardfuture.ai/p/the-cost-of-ai-breakdown-of-investments-in-training-infrastructure-and-more

豫公网安备41010702003375号

豫公网安备41010702003375号