![]() 前沿资讯

1742888315更新

前沿资讯

1742888315更新

![]() 0

0

牛津大学人类未来研究所的研究学者芬·穆尔豪斯(Fin Moorhouse)和人工智能伦理学家威尔·麦卡斯基尔(Will MacAskill)撰写了一份聚焦人工智能发展的重要报告:《为智能爆炸做好准备》。报告指出,人工智能的发展正处于关键节点,智能爆炸带来的一系列巨大挑战亟待人类深思并做好充分准备。

回顾历史,过去一个世纪的技术进步可谓翻天覆地。若将这些进步压缩到1925年后的十年,从首次跨太平洋飞行到人类登月可能仅需四个月,从曼哈顿计划到广岛、长崎原子弹爆炸或许只有三个月。如此剧烈的加速发展,将让世界在决策、制度适应和理解变化上的时间大幅减少。

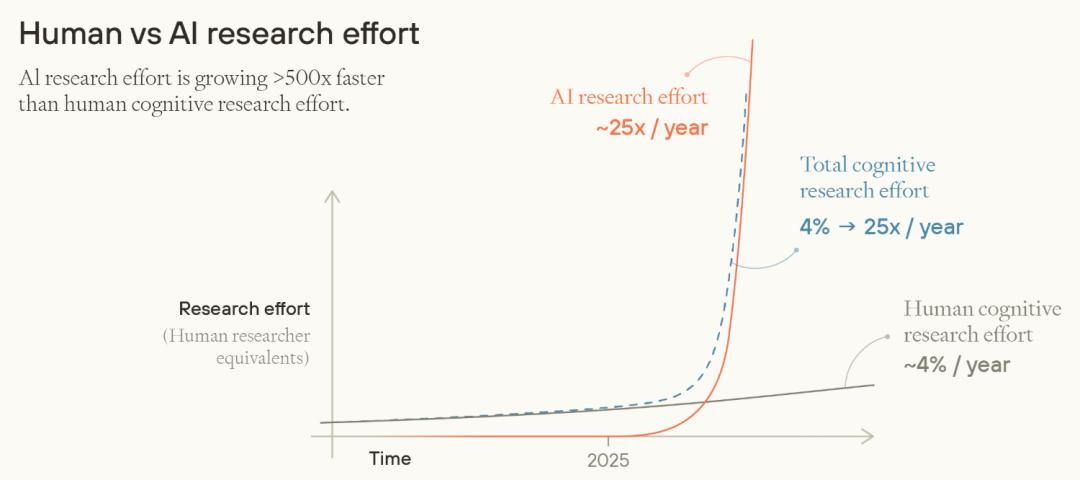

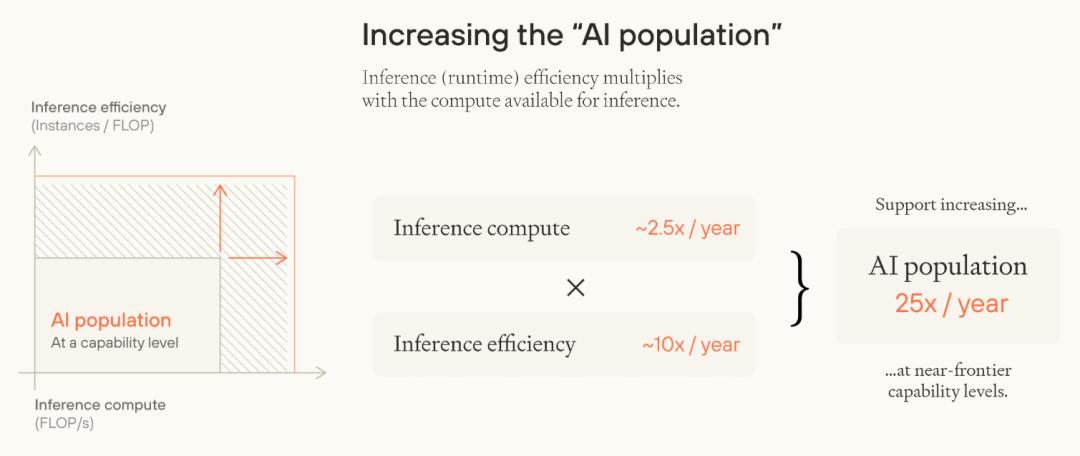

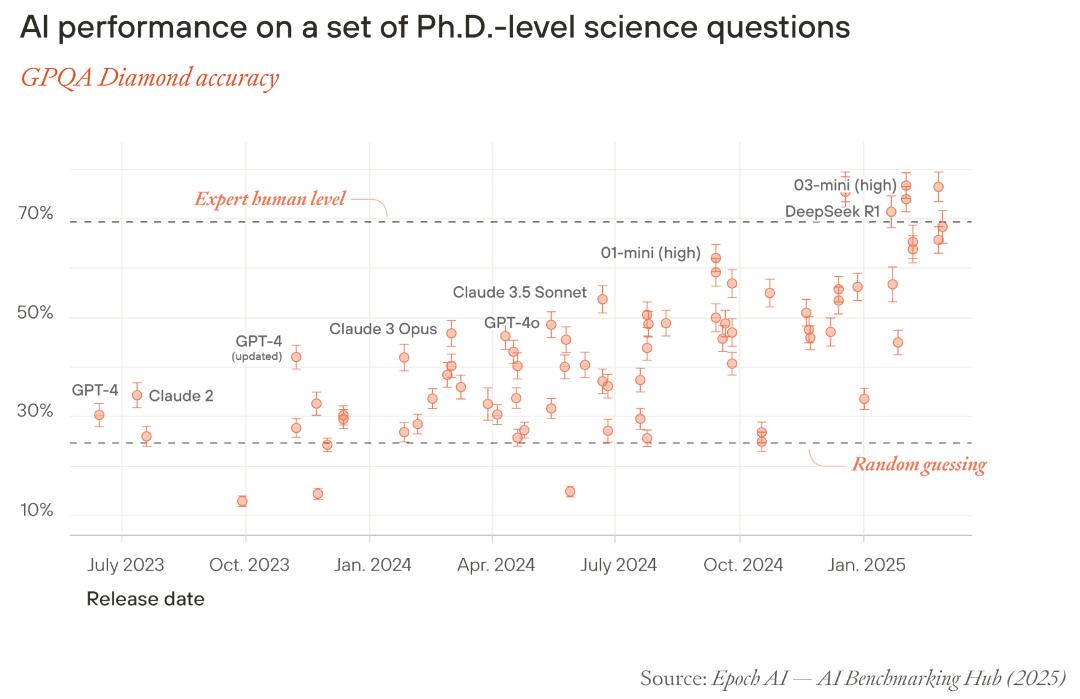

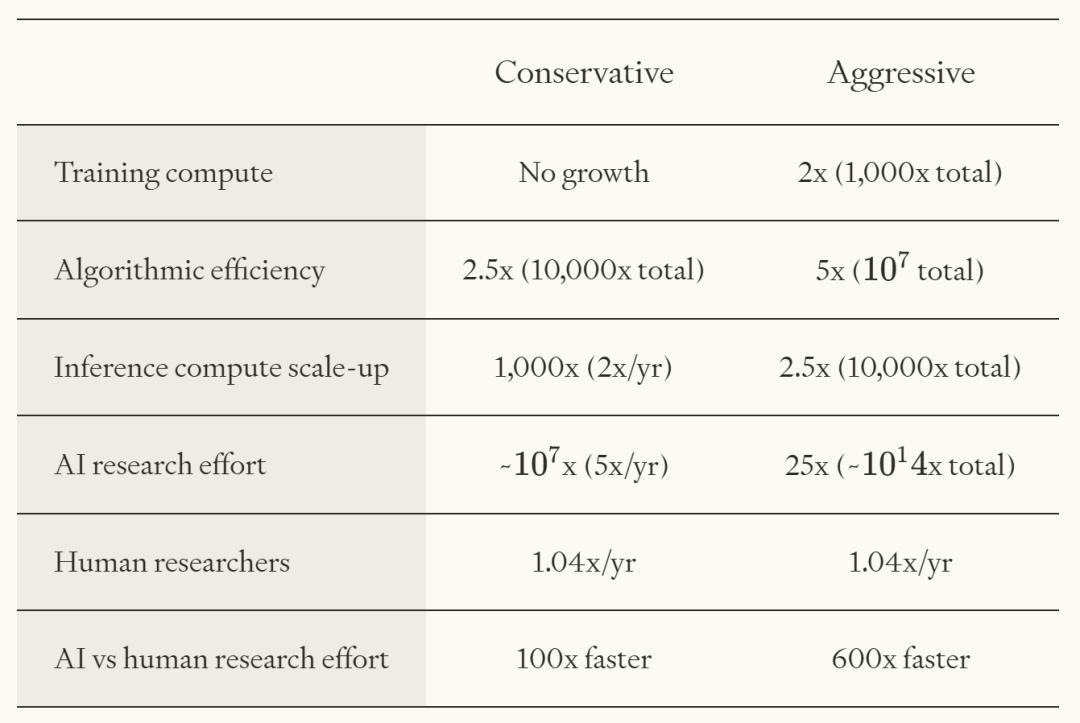

如今,人工智能的崛起正引领着一场类似的科技加速变革。当前,通过对大量AI模型在语言理解、图像识别、逻辑推理等多领域的测试评估得出,AI认知能力每年约增长25倍。与之形成鲜明对比的是,综合了全球范围内科研人员数量增长、科研投入增加以及研究方法改进等多方面因素,人类研究能力每年仅增长4%。随着技术的不断成熟,一旦AI能够深度参与甚至替代人类进行研究工作,那么整体研究的增长将呈现爆发式增长。研究表明,即便面临计算能力扩展停滞、算法效率提升放缓且不存在软件反馈循环(即“递归式自我改进”)的不利情况,AI凭借其现有的发展态势,仍有可能在不到十年的时间里推动相当于过去一百年的技术进步。

AI的快速发展带来了诸多诱人的机遇。在物质层面,有望使人们的生活水平得到极大提升,这种富足程度甚至会让当今的亿万富翁都为之羡慕。借助AI,人类在协调合作、安全保护和民主发展等方面可能取得更大进展。此外,AI还能够实现政策分析和明智决策的自动化,利用大数据分析和机器学习算法,深入剖析政策的潜在影响,为政府决策提供科学依据,帮助人们更好地应对各类复杂问题。

然而,智能爆炸也带来了一系列棘手的挑战。在权力层面,存在政治领袖或AI公司高管利用AI巩固权力的风险。一些国家的政治人物可能借助AI分析选民心理,制定更具倾向性的竞选策略,从而操纵选举结果。AI公司也可能凭借技术优势,获取大量用户数据,进一步扩大自身影响力。同时,忠诚的自动化军队和官僚机构可能会成为独裁政权巩固统治的工具,使政权更加稳固,并且固化特定的意识形态。

在认知领域,超级智能顾问可以在人们做出重要决策时提供全面、精准的信息和建议,帮助人们更好地权衡利弊。AI超级预测者能够通过对海量数据的分析,预测未来趋势,为社会发展提供前瞻性指导。但另一方面,具有超强说服力的AI可能会被用于传播有害意识形态,通过社交媒体平台精准推送极端思想,煽动社会对立,或者给寻求建议的人提供不道德、不择手段的策略,误导人们的行为。

面对这些挑战,有部分观点认为,只要让超级智能与人类目标保持一致,就能解决所有问题,从而忽视当下的准备工作。但这种想法并不全面。许多挑战在超级智能成熟之前就已经出现,例如AI在数据隐私保护、算法偏见等方面的问题,已经对社会产生了影响。还有,一些解决问题的机会窗口可能很快关闭,比如在国际合作制定太空资源开发规则方面,如果各国不能及时达成共识,可能会引发资源抢夺的混乱局面。此外,确保超级智能的帮助能精准惠及合适的人也至关重要,否则可能会加剧社会不平等。

为此,报告中提出了一系列应对建议。在推动AI合理应用方面,应加强对AI研发和应用的监管,建立严格的技术标准和伦理准则,确保AI技术符合人类价值观。同时,要加大在教育领域的投入,培养具备AI素养的专业人才,提高公众对AI的认知和理解能力,让更多人能够参与到AI的发展和治理中来。

人工智能驱动的智能爆炸是一场不可避免的科技革命,它既为人类社会带来了前所未有的机遇,也让我们面临着诸多复杂的挑战。人类必须高度重视,积极行动起来,提前做好充分准备,才能在这场科技变革中把握主动,实现可持续发展,让人工智能真正造福人类社会。

参考资料:https://www.forethought.org/research/preparing-for-the-intelligence-explosion

豫公网安备41010702003375号

豫公网安备41010702003375号