![]() 前沿资讯

1746873235更新

前沿资讯

1746873235更新

![]() 0

0

大语言模型在众多任务中表现出色,但由于其知识局限于预训练数据,容易产生幻觉内容或提供过时信息,从而影响其可靠性。为了解决这一问题,检索增强生成(RAG)技术应运而生。该技术通过整合外部知识来提升模型的生成表现,但这种方法对提示工程要求极高,且对模型的推理能力有较大依赖。

后续研究,又提出了监督微调策略,以提高较小规模大语言模型的性能,同时也出现了如蒙特卡洛树搜索(MCTS)等测试时缩放技术,该技术在模型推理阶段,通过动态调整搜索空间等方式可显著提升模型性能。虽然这些方法取得了一定成果,但仍面临计算成本高昂等问题,也限制了其实际应用。

在此背景下,阿里巴巴团队提出了一种名为ZeroSearch(零交互搜索)的强化学习框架。该框架利用语言模型在大规模预训练过程中积累的广泛世界知识,通过轻量级监督微调,将语言模型转化为一个检索模块。这个检索模块能够根据查询生成相关文档,甚至模拟出不太准确的信息,以此来模拟真实搜索引擎的行为。

在训练过程中,ZeroSearch引入了一个基于课程学习的滚动策略。初始阶段,给模型的任务比较简单,随着训练的推进,让模型接触越来越复杂的检索场景,逐步提升其推理能力,这样它的推理能力就能一步步提高。奖励机制方面,研究人员发现,如果简单地用答案是否完全匹配来奖励模型,模型可能会“耍小聪明”,给出很长很长的答案,只为了增加答对的机会。所以,他们采用了基于F1分数的奖励函数,这个函数能更合理地衡量答案的质量,让模型更认真地去找真正准确的答案。

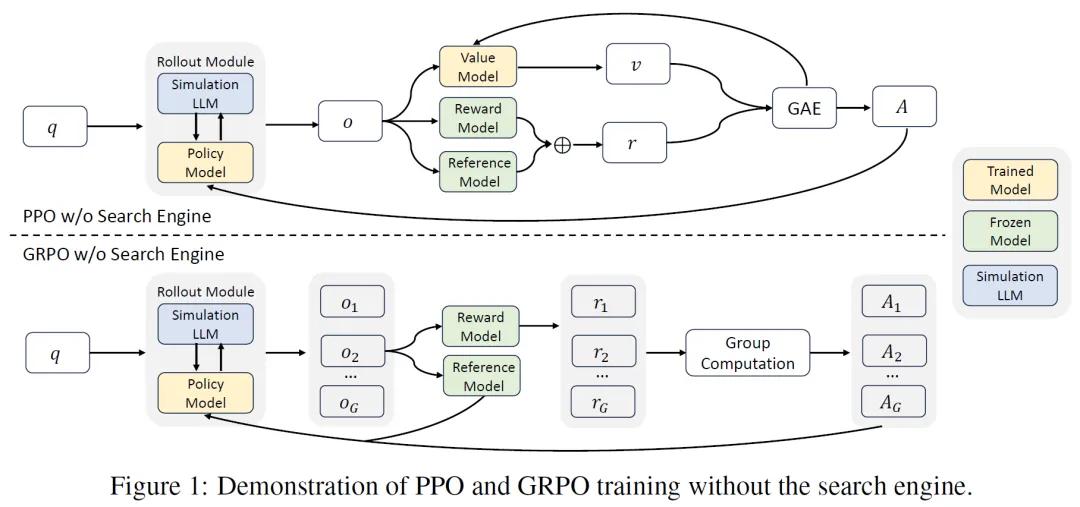

ZeroSearch兼容性也特别强,像PPO、GRPO这些常见的强化学习算法,它都能很好地配合。而且,为了让训练更稳定,它还设计了一种损失掩码机制,这样就能保证训练的时候不受一些外部干扰,让模型学习得又快又好。

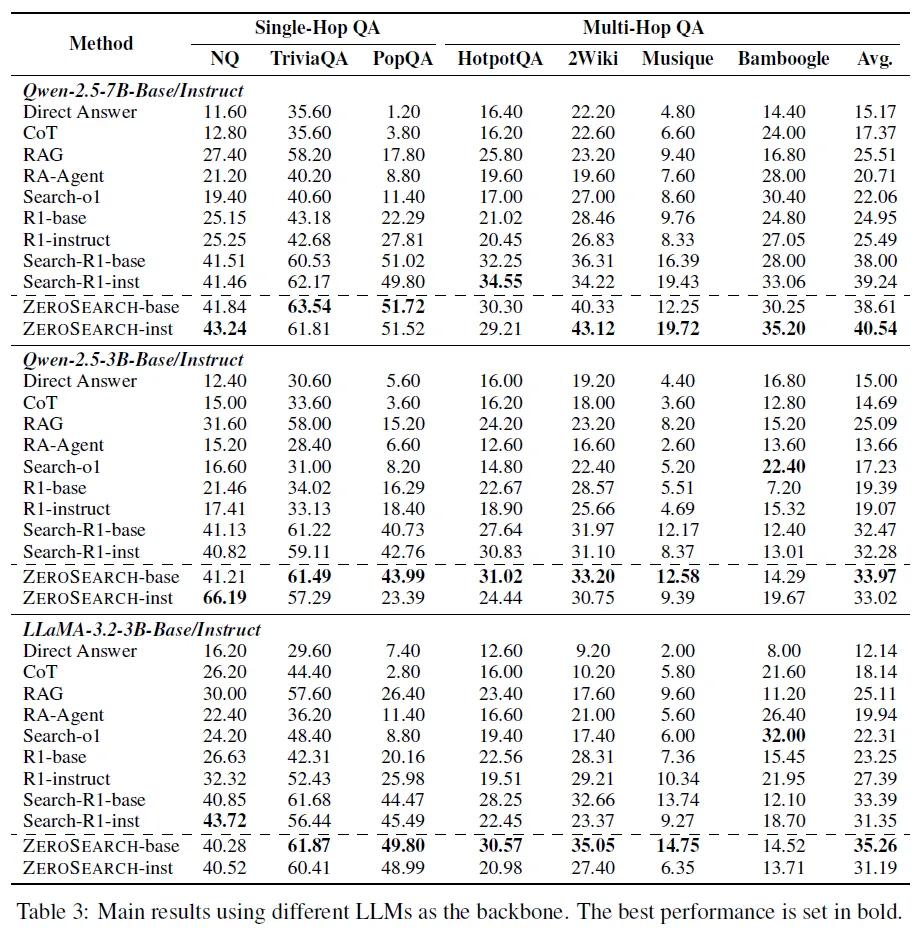

研究团队对ZeroSearch进行了广泛的实验评估,用了各种问答测试数据集,还与其他方法进行了对比。结果显示,ZeroSearch的表现特别突出,不管是在单一问题的问答,还是需要多步推理的复杂问答中,都比其他方法表现更优,甚至比那些依赖真实搜索引擎的模型表现还好。而且,不管是参数少一点的小模型,还是参数多的模型,ZeroSearch都能显著提升其性能。

ZeroSearch也存在一定局限性,比如部署模拟搜索模型需要GPU服务器,会带来额外的基础设施成本。不过,研究团队表示,与商业API的使用成本相比,这一成本仍然较低,并且可以通过共享服务器等策略进一步降低。

ZeroSearch框架为提升模型搜索能力提供了创新解决方案,有望为更多应用场景提供支持。

参考资料:https://arxiv.org/abs/2505.04588

豫公网安备41010702003375号

豫公网安备41010702003375号