![]() 前沿资讯

1749801747更新

前沿资讯

1749801747更新

![]() 1

1

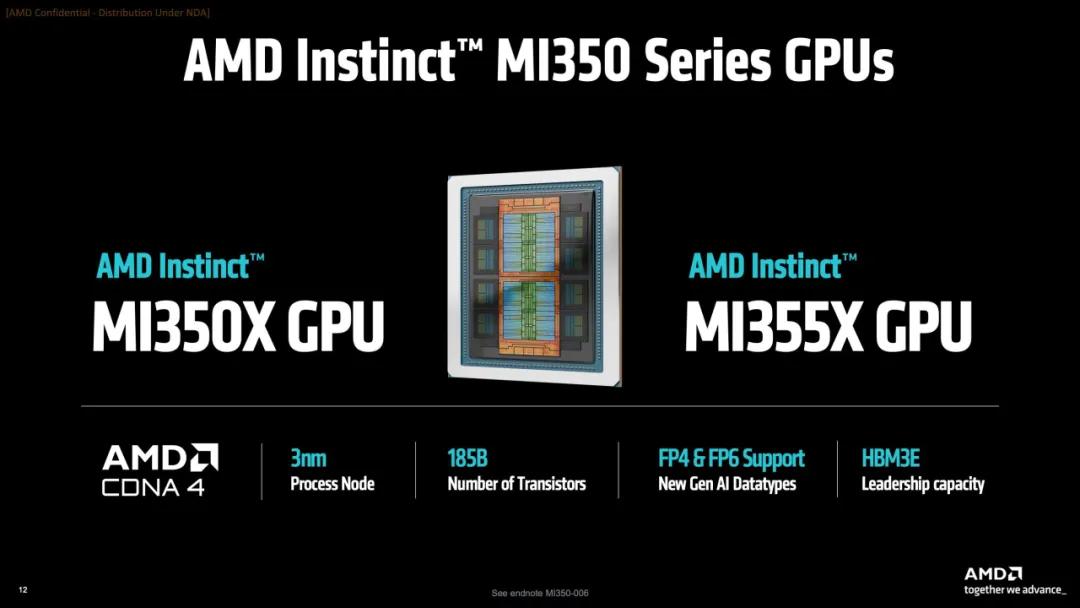

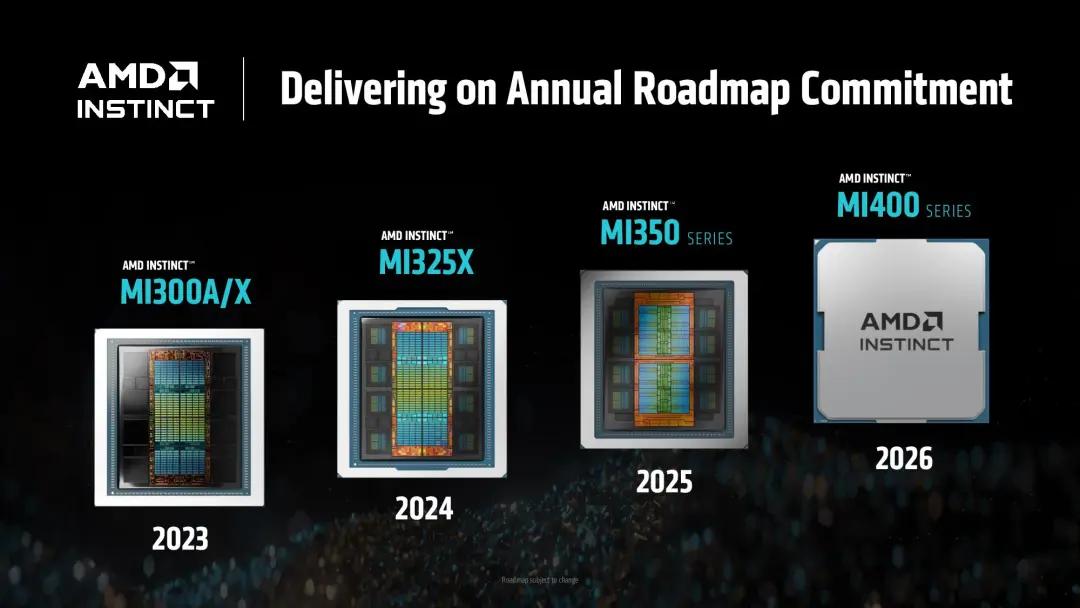

在美国加州圣何塞举行的“Advancing AI 2025”活动上,AMD正式发布新一代AI加速器产品MI350X与MI355X。这两款产品基于全新CDNA 4架构,配备更大容量的HBM3E显存,并支持低精度运算格式FP4和FP6,专为满足AI推理与训练需求而设计。

AMD表示,相较于上一代MI300X,MI350X与MI355X在AI计算性能方面提升最高可达4倍,在推理性能方面提升则高达35倍。根据内部测试结果,MI355X在Llama 3.1 405B推理任务中,相较搭载英伟达GB200的系统可实现约1.3倍性能提升。在DeepSeek R1测试中,使用8张MI355X的系统相较英伟达B200 HGX提升约1.2倍,在部分训练任务中,性能则领先约1.13倍。

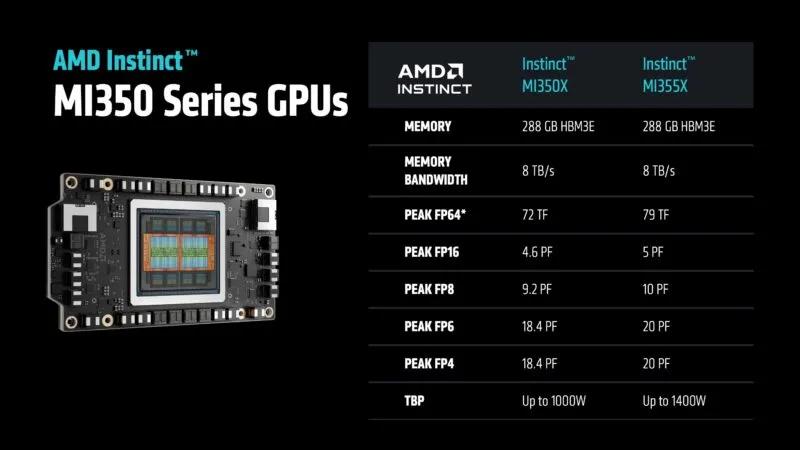

新发布的两款产品在设计上保持一致,均搭载最多288GB HBM3E显存,内存带宽高达8TB/s,并支持多种精度格式,包括FP64、FP32、FP16、FP8、FP6和FP4。两者的主要区别在于散热方式:MI350X采用风冷设计,适用于对功耗有更高要求的部署环境,MI355X采用液冷方案,可实现更高的整板功耗上限,达1400W,以换取极致性能表现。

在性能表现方面,标准版MI350X的FP4/FP6精度峰值为18.45 PFLOPS,FP8精度为约9.3 PFLOPS,而MI355X的对应指标则提升至20.1 PFLOPS(FP4/FP6)和10.1 PFLOPS(FP8)。在纸面性能上,两者均高于英伟达最新发布的Blackwell Ultra(B300 GPU),后者FP4峰值为15 PFLOPS。但实际运行效率与表现仍有待进一步测试和验证。

据AMD首席技术官马克·佩珀马斯特(Mark Papermaster)在国际超级计算大会ISC 2025演讲中指出,未来超级计算性能如欲迈入ZettaFLOPS级别,其功耗将随之显著增加。为支撑这一性能级别,未来的超算系统可能需要高达500兆瓦的供电能力,这一数值相当于半座核电站的输出功率。

从最初的CPU单打独斗,到2005年后引入的CPU+GPU异构架构,再到如今的AI加速阶段,系统峰值性能基本保持每1.2年翻一番的增长曲线。而随着计算密度的提升,内存带宽需求也同步上升。为了维持内存带宽与计算能力之间的配比关系,GPU所搭载的高带宽内存HBM堆栈数量也持续增加,导致GPU封装体积和功耗逐年增长。

根据AMD的公开路线图,从2023年MI300X的750瓦起步,到MI355X的1400瓦,AMD已规划在2026–2027年间推出功耗达到1600瓦的下一代加速器。长期来看,AMD预计未来高端加速器的功耗可能进一步增长至2000瓦。同时,竞争对手英伟达的Rubin Ultra加速器功耗据称将达到3600瓦。

虽然功耗持续上升,AMD也强调了能效提升所带来的积极影响。以Frontier超算为例,其单位功率计算性能已从2010年约3.2 GFLOPS/W提升至当前的52 GFLOPS/W。若要实现ZettaFLOPS级别的计算系统,行业需进一步提升能效比至2140 GFLOPS/W,相当于在现有基础上再提升41倍。马克指出,若未能达成这一目标,整个系统的功耗将接近甚至超过大型核电站的供电能力,运营成本将大幅提升。

参考资料:https://www.tomshardware.com/pc-components/gpus/amd-announces-mi350x-and-mi355x-ai-gpus-claims-up-to-4x-generational-gain-up-to-35x-faster-inference-performance

豫公网安备41010702003375号

豫公网安备41010702003375号