![]() 前沿资讯

1751020136更新

前沿资讯

1751020136更新

![]() 0

0

今日,腾讯正式发布并开源混元-A13B模型。该模型采用混合专家(MoE)架构,总参数达800亿,激活参数130亿,在保持与顶尖开源模型相当效果的同时,大幅降低了推理延迟和计算开销。

据了解,该模型在预训练阶段采用了20万亿高质量网络词元语料,大幅提升了推理能力上限。同时,混元团队进一步完善了MoE架构的Scaling Law理论,提出一套工程化、可量化的设计指导方案,有效提升了MoE模型的训练与推理表现。

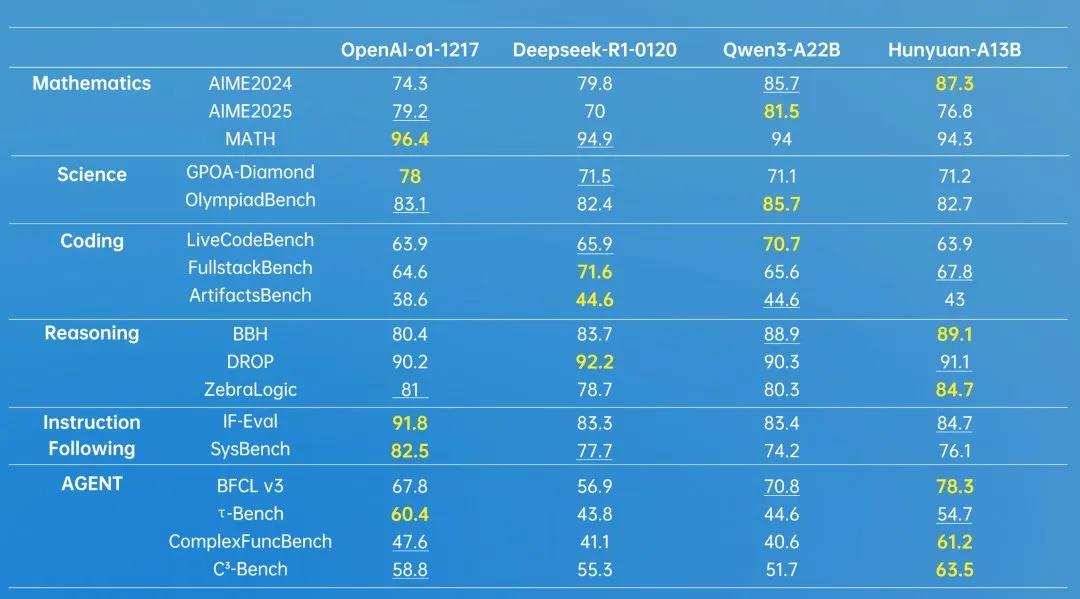

在实际测试中,混元-A13B展现出强大的数学与逻辑推理能力,面对“9.11和9.9谁大”这类基础问题,模型不仅轻松给出准确答案,还可分步骤解析问题。在当前大热的智能体(Agent)场景中,混元-A13B还具备调用外部工具的能力,能够高效执行如出行规划、文件分析等复杂任务。另外,模型还支持“快思考”与“慢思考”两种推理模式。“快思考”输出简洁高效,适用于轻量级任务,“慢思考”则提供更深入的推理,兼顾任务复杂度与输出准确性,进一步优化计算资源使用。

为推动行业标准建设,腾讯此次还同步开源了两个重要评估数据集:

ArtifactsBench:专为代码生成与理解任务而设计,包含1825个任务,用于模型在程序理解、修复等方面的评估。

C3-Bench:面向智能体(Agent)任务评估,涵盖1024条高质量测试数据,重点衡量模型在工具使用、任务规划等多环节能力。

这两套数据集可以为行业提供更系统、更细化的开源大模型评估基准,填补了当前评估工具链的部分空白。

面对AI模型高昂的部署门槛,混元-A13B的优势尤为突出。得益于MoE架构的选择性激活机制,即使在极端资源受限的条件下,仅需一张中低端GPU显卡即可完成部署。这对于资源有限的独立开发者、小型企业乃至教育研究机构而言,都是一项关键利好。

业内分析认为,混元-A13B的发布,标志着国产开源大模型在性能-效率-成本三者之间的平衡实现突破。其轻量部署能力与全面推理能力的结合,将为推动AI普惠化提供有力技术支撑。该模型现已在Github、HuggingFace等技术社区上线,同时模型API也已登录腾讯云官网。用户可通过混元官网在线体验模型能力。

参考资料:https://x.com/TencentHunyuan/status/1938525874904801490;腾讯混元新成员,轻量好用&开源

豫公网安备41010702003375号

豫公网安备41010702003375号