![]() 前沿资讯

1751441474更新

前沿资讯

1751441474更新

![]() 0

0

今天,智谱AI正式发布新一代多模态视觉语言模型GLM-4.1V-Thinking系列,并率先开源了一个90亿参数量的9B-Thinking模型。该模型由智谱与清华大学联合研发,以通用化多模态推理为核心目标,凭借创新的推理中心训练框架,在众多任务中展现出卓越性能。

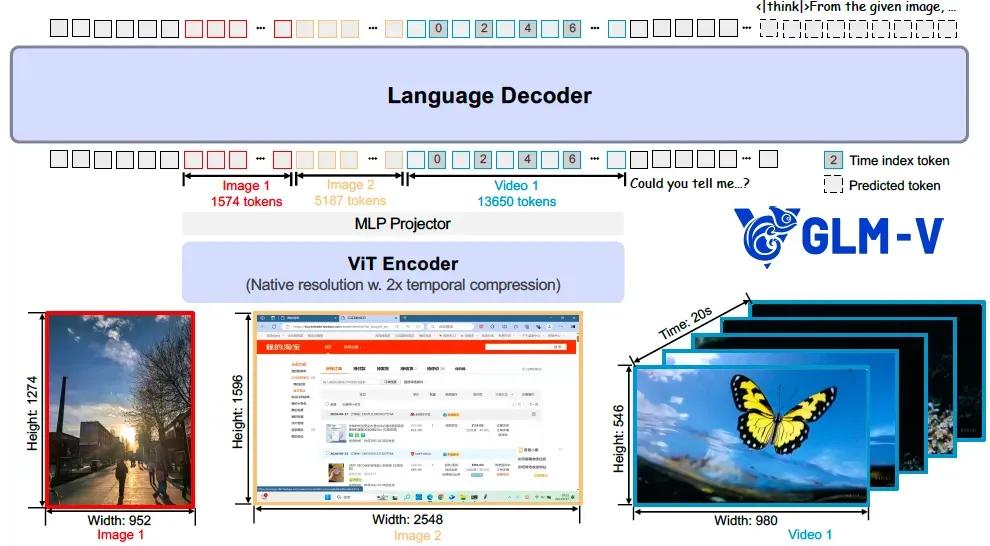

据介绍,GLM-4.1V-Thinking由AIMv2-Huge视觉编码器、MLP投影层和GLM解码器三部分组成。视觉编码器方面,引入了3D卷积实现视频输入的时间维度建模,同时采用二维旋转位置编码(2D-RoPE)与可学习绝对位置嵌入,支持极端比例与高分辨率图像处理。语言解码器则实现了三维旋转位置编码(3D-RoPE),提升模型在多模态输入下的空间理解能力和文本生成表现。

智谱为GLM-4.1V-Thinking设计了“三阶段”训练体系。在预训练阶段,模型接受了多模态数据(图文、OCR、视频帧、图表等)训练,序列长度最长扩展至32K tokens,构建了强大的基础视觉语言理解能力。在监督微调(SFT)阶段,构建了高质量“思维链”数据集,训练模型进行因果式图文推理与复杂任务规划,进一步提升了逻辑严谨性。

在课程采样强化学习(RLCS)阶段,通过结合人类反馈(RLHF)与可验证奖励(RLVR),对多个关键任务进行由浅入深的强化训练,实现了实用性与稳健性的全面提升。

该模型融合了包括图像问答、视频理解、文字识别、图表提取、学科看图解题、文档解析、界面交互识别(GUI Agent)以及看图生成前端代码等在内的丰富能力。其中,在长达两小时的视频理解任务中,GLM-4.1V-9B-Thinking可准确解析时间线、人物角色与事件逻辑,展现出远超同级模型的深度理解能力。

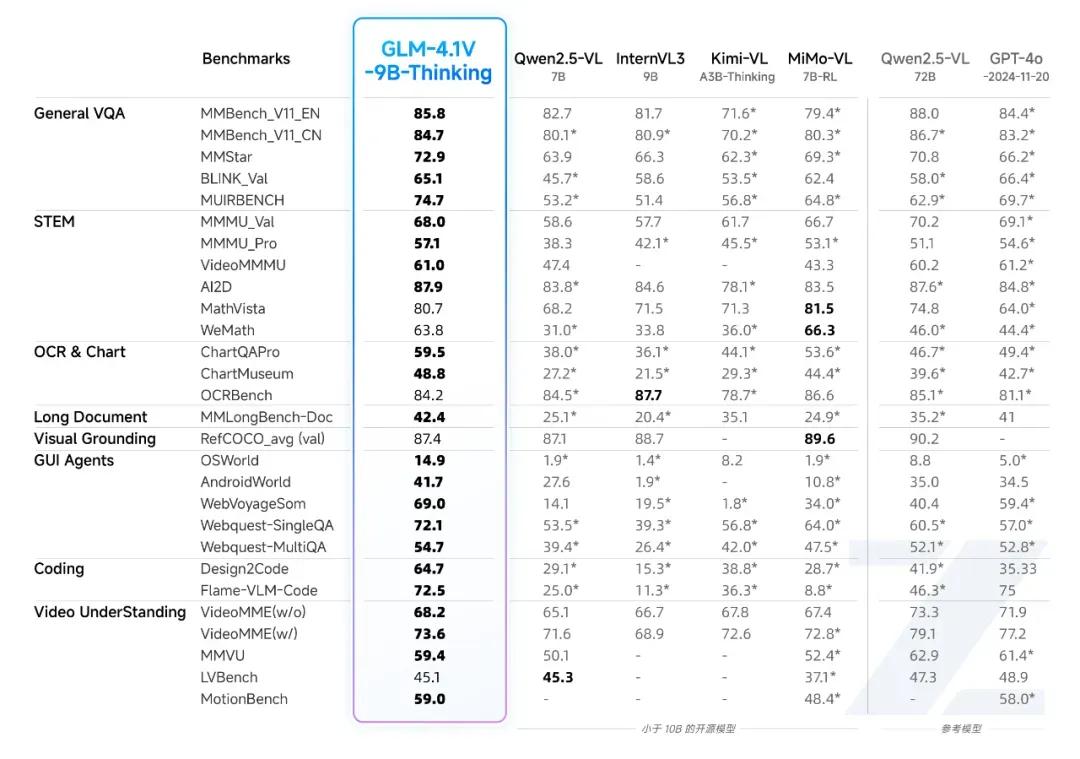

GLM-4.1V-Thinking在多个复杂视觉推理任务中表现优异,整体性能达到了10B级别视觉语言模型的领先水平。

GLM-4.1V-9B-Thinking基于“思维链(Chain-of-Thought)”推理机制,在回答准确性、内容深度与可解释性方面全面领先。在28项评测任务中,有23项取得10B级别模型最佳成绩,18项任务超越了规模高达720亿参数的Qwen2.5-VL-72B,展示出其在结构设计与训练效率方面的显著优势。

参考资料:GLM-4.1V-Thinking 模型开源;https://arxiv.org/abs/2507.01006

豫公网安备41010702003375号

豫公网安备41010702003375号