![]() 前沿资讯

1766649140更新

前沿资讯

1766649140更新

![]() 0

0

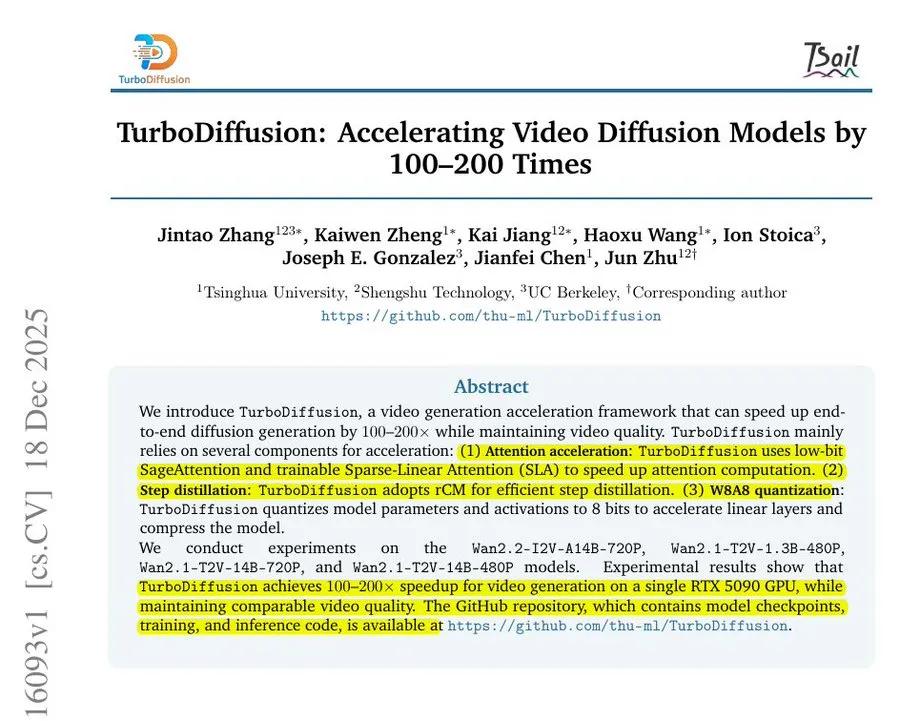

导读:字节跳动与清华大学联合公开 TurboDiffusion,这是一个面向视频扩散模型的推理加速框架,在单张 RTX 5090 上实现 100–200 倍提速,同时画质损失很小,目标直指实时 AI 视频生成。

字节跳动与清华大学近期同步公开了 TurboDiffusion 的 GitHub 项目与论文。这项工作聚焦一个长期存在的行业痛点:视频扩散模型生成速度太慢,算力成本过高。

在现有方案中,视频扩散模型往往需要上百次去噪步骤,每一步内部都要执行高开销的注意力计算和线性层运算,哪怕是高端 GPU,也很难做到“即点即出”。TurboDiffusion 的核心思路,就是从根本上压缩推理步骤,同时把最重的计算路径跑到最快的硬件通道上。

首先,在采样步骤上,TurboDiffusion 通过一种名为“分数正则化连续时间一致性蒸馏”的方法,将原本约 100 步的采样过程,压缩到 3–4 步。这一步,直接决定了整体推理时间能否被“砍到数量级”。

其次,在注意力计算上,TurboDiffusion 结合了稀疏线性注意力和低比特 SageAttention,只保留 Top-K 的关键注意力连接,并让计算尽可能走 GPU 的 Tensor Core 快速路径,大幅降低了注意力模块的实际计算量。

在密集矩阵计算部分,框架采用 W8A8 量化方案,将权重和激活统一压缩为 8 位整数,同时配合 128×128 的分块量化,以及融合后的 LayerNorm 与 RMSNorm 内核,进一步减少访存和算子开销。

这些优化最终体现在实测数据上。在 RTX 5090 上,Wan2.1-T2V-14B-720P 的生成延迟从 4767 秒降至 24 秒,提速达 199 倍。1.3B-480P 版本则从 184 秒降至 1.9 秒,提速 97 倍(不包含文本编码与 VAE 解码时间)。

在与 FastVideo 的对比中,TurboDiffusion 在同规模模型上依然保持更快的推理速度,同时生成结果在视觉上保持相近水准。

但需要注意的是,这种极端的推理提速并非“免费午餐”。TurboDiffusion 的代价在于额外的训练成本,以及针对推理阶段定制化的算子与内核工程工作。但对于目标明确、追求实时或准实时视频生成的场景来说,这样的取舍显然具有现实价值。

整体来看,TurboDiffusion 展示了一条清晰的技术路径:通过“极少步数 + 稀疏注意力 + 低比特量化”,把大规模视频扩散模型从“慢实验”推向“可实时应用”。这也为后续视频生成系统的工程化落地,提供了一个可复用的参考范式。

参考资料:https://arxiv.org/pdf/2512.16093

豫公网安备41010702003375号

豫公网安备41010702003375号