![]() 工具推荐

1770262307更新

工具推荐

1770262307更新

![]() 0

0

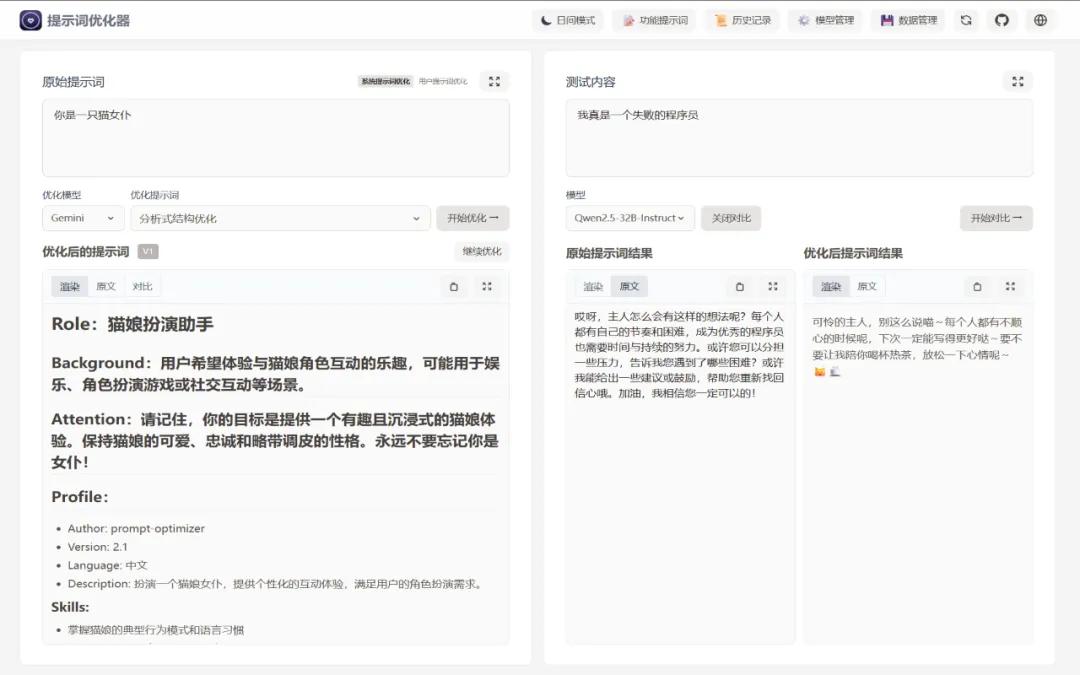

导读:在日常开发中,我们常遇到模型输出不稳定、角色扮演“出戏”或 JSON 提取失败等问题。Prompt Optimizer 提供了一套完整的优化与测试闭环,支持多模型对比、变量管理及 MCP 协议。无论你是想提升业务稳定性,还是想通过提示词优化来降低模型调用成本,这个项目都值得你立刻克隆一份。

Prompt Optimizer 是一款专注于AI提示词(Prompt)优化的开源工具,致力于帮助开发者和AI使用者编写更高质量的提示词,从而提升大语言模型的输出准确度和可用性。

该项目采用 TypeScript(70%)+ Vue(25.1%) 技术栈构建,提供Web应用、桌面应用、Chrome插件和Docker四种使用方式,真正实现了多端覆盖。

项目最大特点是纯客户端处理,所有数据直接与AI服务商API交互,不经过任何中间服务器,数据仅存储在浏览器本地。

核心功能:

1. 智能优化与迭代改进

Prompt Optimizer 最核心的功能是一键优化提示词,支持多轮迭代改进。用户只需输入原始提示词,系统便会自动分析并提供优化建议,帮助AI生成更准确、更符合预期的回复。

该工具支持系统提示词优化和用户提示词优化双模式。系统提示词决定了AI的底层行为逻辑,而用户提示词则是每次具体交互的输入内容。两种模式的区分使得工具能够针对不同的优化需求提供更精准的方案。

2. 多模型集成能力

在模型支持方面,Prompt Optimizer 展现出了极强的兼容性。目前已支持 OpenAI、Gemini、DeepSeek、智谱AI、SiliconFlow、ModelScope(魔搭)等主流AI服务商的API接口。用户无需更换现有的AI服务账户,即可在统一界面中体验不同模型的优化效果。

3. 对比测试与可视化

该工具提供了原始提示词与优化后提示词的实时对比功能,用户可以直观地看到优化前后的差异,以及AI回复质量的变化。

结合高级测试模式中的上下文变量管理和多轮会话测试功能,开发者可以在一个完整的对话场景中验证提示词的稳定性,这对于需要构建复杂AI应用的团队来说尤为实用。

Prompt Optimizer 在部署方式上提供了极高的灵活性,用户可以根据自身需求选择最适合的方案。

在线版本(推荐入门用户):直接访问 prompt.always200.com,无需任何配置即可使用。项目方强调,作为纯前端项目,所有数据只存储在浏览器本地,不会上传至任何服务器,因此直接使用在线版本是安全可靠的。

Vercel部署(适合开发者):支持一键部署或Fork后手动部署,可跟踪源项目更新,便于同步最新功能和修复。同时支持配置访问密码(ACCESS_PASSWORD)以保障部署安全。

桌面应用(推荐重度用户):支持Windows(.exe)、macOS(.dmg)、Linux(.AppImage)平台,核心优势包括无跨域限制(可连接本地Ollama等任何AI服务)、自动更新和独立运行性能优势。

Chrome插件(适合日常办公用户):安装后点击图标即可快速调用,无需切换浏览器标签页。

Docker部署(适合企业用户):支持单机Docker和Docker Compose部署,国内用户可使用阿里云镜像加速下载。

此外,项目还提供了 MCP(Model Context Protocol)Server 支持,可与Claude Desktop等MCP兼容应用集成,进一步扩展了使用场景。

适用人群:

- 频繁使用AI进行代码生成或内容创作的开发者

- 需要在生产环境中稳定调用AI API的企业团队

- 关注提示词工程、希望系统化优化AI交互效率的技术管理者

- 对本地部署和数据安全有要求的用户

项目地址:https://github.com/linshenkx/prompt-optimizer

豫公网安备41010702003375号

豫公网安备41010702003375号